针对DeepSeek近期因访问量激增导致的服务器繁忙问题,以下是几种有效的平替方案,涵盖本地部署、第三方平台接入及其他替代工具推荐:

1. 先说结论

方案一:接入DeepSeek的第三方平台。

适合普通大众或小白用户,无需折腾,打开网页即可使用。

方案二:第三方平台的API。

适合对推理能力和思考深度有较高要求的用户。缺点是会稍微麻烦一点,需要自己完成一些配置。

方案三:本地化部署。

适合技术团队或IT从业者,对电脑的硬件性能和用户的部署能力都有一定的要求。若对数据隐私和长期使用有较高要求的用户,可考虑将模型部署在本地环境。

2. 方案介绍及操作流程

2.1. 方案一:接入DeepSeek的第三方平台

2.1.1. 超算互联网平台

- 简介: 超算互联网平台是一种基于高速网络与先进调度技术的国家级算力基础设施,旨在将分散的超级计算机中心集中管理,提供统一的访问接口。

- 网址: https://chat.scnet.cn/#/home

- 新闻: 超算互联网上线DeepSeek系列模型,提供超智融合算力支持

- 示例:

2.1.2. 秘塔AI搜索

- 简介: 秘塔AI搜索是一款基于人工智能技术的新一代搜索引擎,通过结合大语言模型与智能检索能力,旨在提供更精准、高效的答案式搜索体验,尤其在中文信息处理场景中表现出色。

- 网址: https://metaso.cn/

- 新闻: 秘塔AI接入满血版DeepSeek R1推理模型

- 示例:

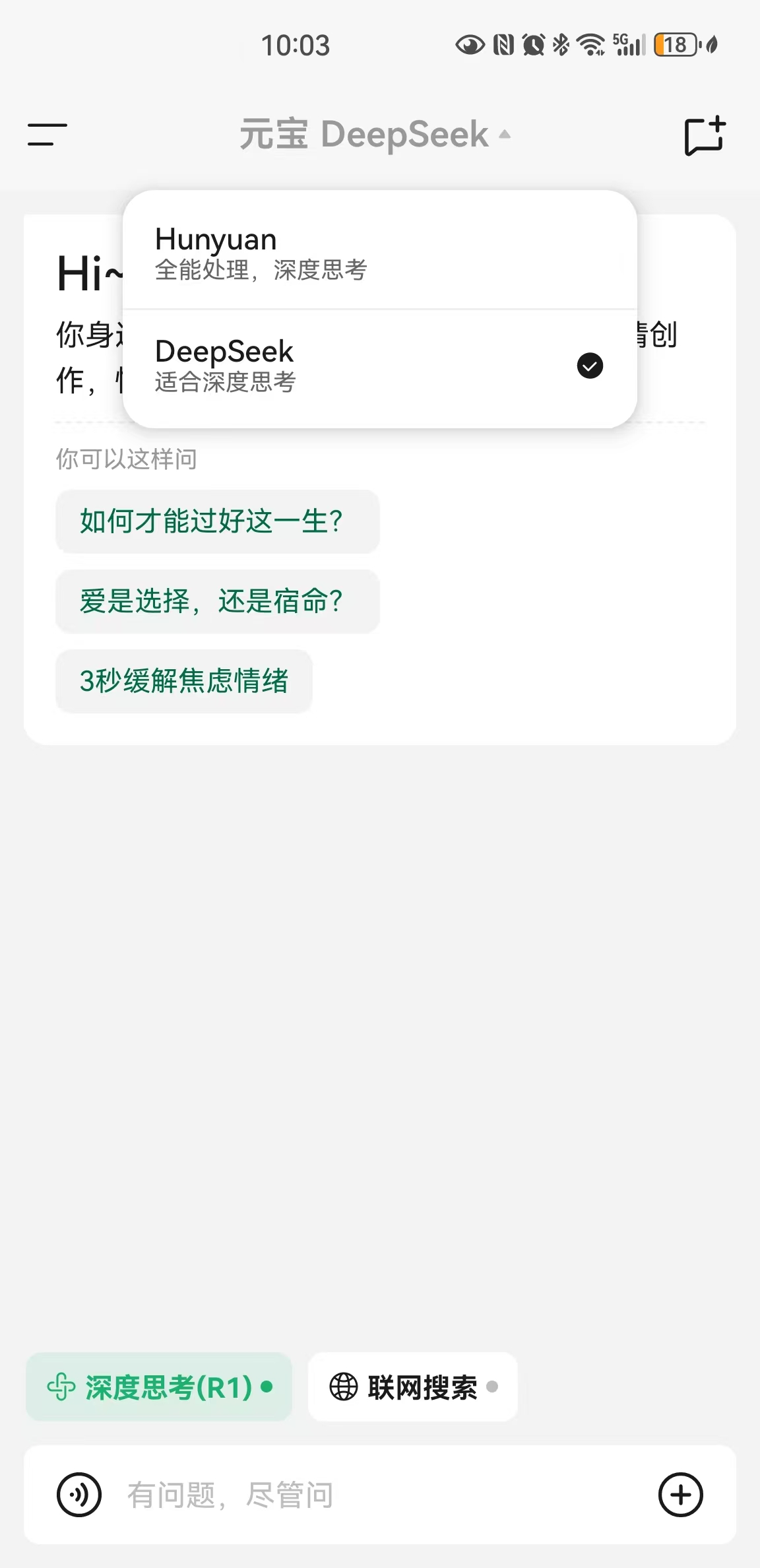

2.1.3. 腾讯元宝

- 简介: 腾讯元宝是腾讯推出的一个AI驱动的聊天机器人或虚拟助手产品,旨在为用户提供智能化的对话服务和信息查询。支持网页版和移动端App。

- 网址: https://yuanbao.tencent.com/chat/

- 示例:

2.1.4. ima.copilot

- 简介: 会思考的知识库,开启搜读写新体验,支持 DeepSeek R1 满血版。支持平台:macOS、Windows、小程序。

- 网址: https://ima.qq.com/

- 示例:

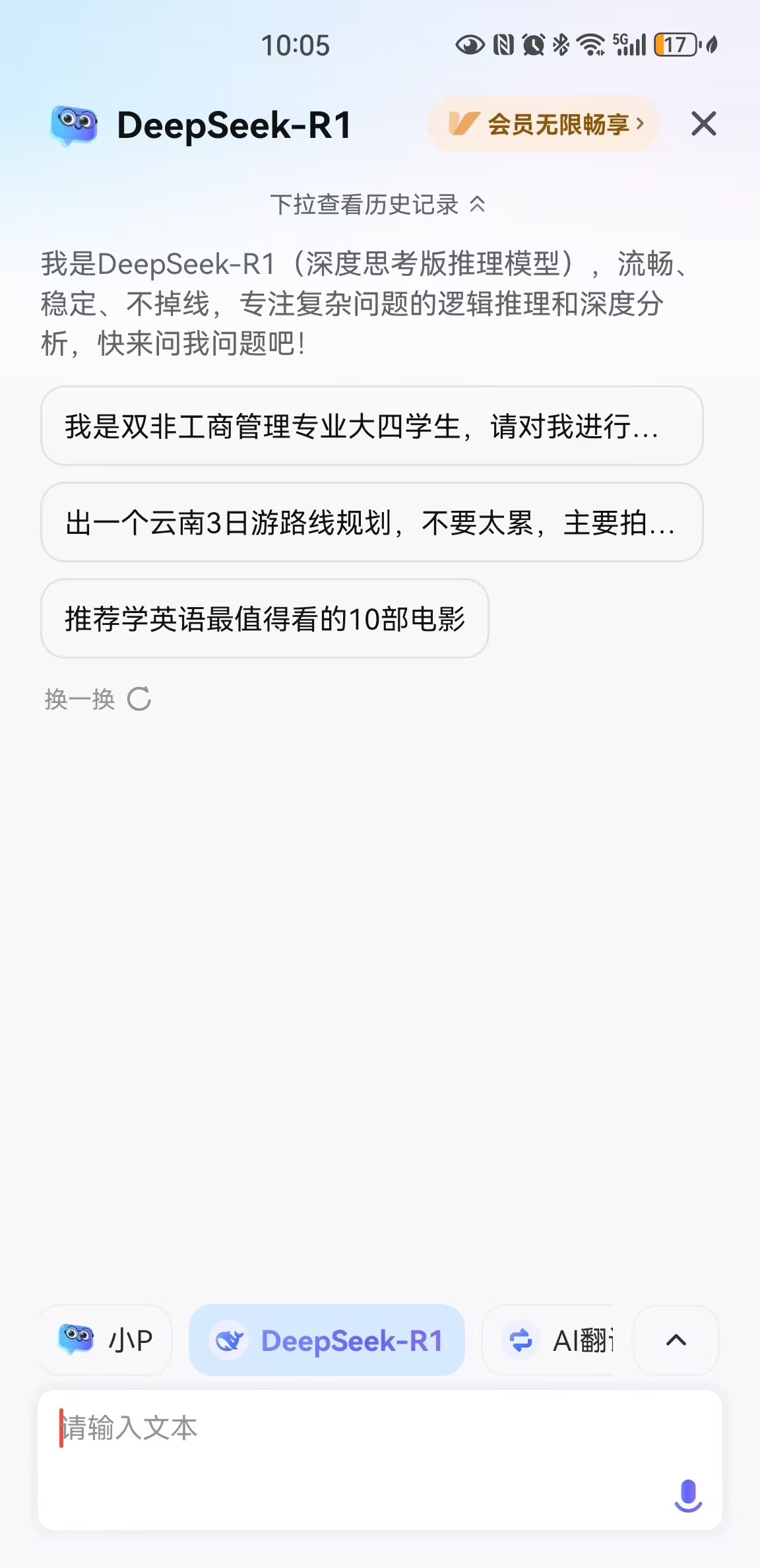

2.1.5. 有道词典-AI助手

简介: 有道词典AI助手是网易有道词典集成的一款智能语言学习工具,依托先进的自然语言处理技术(如大语言模型),为用户提供更智能、交互式的语言服务。以下是其核心特点:

网址: 好像只有移动端App支持。

示例:

2.2. 方案二:第三方平台的API

2.2.1. 实现原理

原理说明:

该方案的核心原理是: 通过硅基流动提供的DeepSeek API来提供大语言模型服务,然后用多模型桌面客户端(如Cherry Studio或Chatbox),通过API的密钥连接硅基流动提供的服务。

硅基流动:

与DeepSeek类似,硅基流动(全称北京硅基流动科技有限公司)是中国另外一家初创的AI科技公司,是一家专注于AI基础设施(AI Infra)的公司。简单来说,这家公司研发的平台(中文:硅基流动,英文:SiliconFlow)就像是为开发者和企业提供“AI模型超市”和“加速工具包”。通过整合先进的大模型(如文本生成、图像生成等)并优化其性能,硅基流动让用户无需从零开始训练模型或购买昂贵硬件,就能快速、低成本地使用AI能力。

硅基流动与华为云联合推出基于昇腾云的DeepSeek R1&V3服务。他们三者之间的关系如下:。

- 昇腾云: 是华为云的一个服务,它基于华为的昇腾芯片提供算力支持。

- 硅基流动: 是一个集成多模型的云服务平台。

- DeepSeek: 提供大模型推理服务。

2.2.2. 硅基流动 + Cherry Studio的操作流程

这里以 硅基流动 + Cherry Studio为例,讲解操作流程。

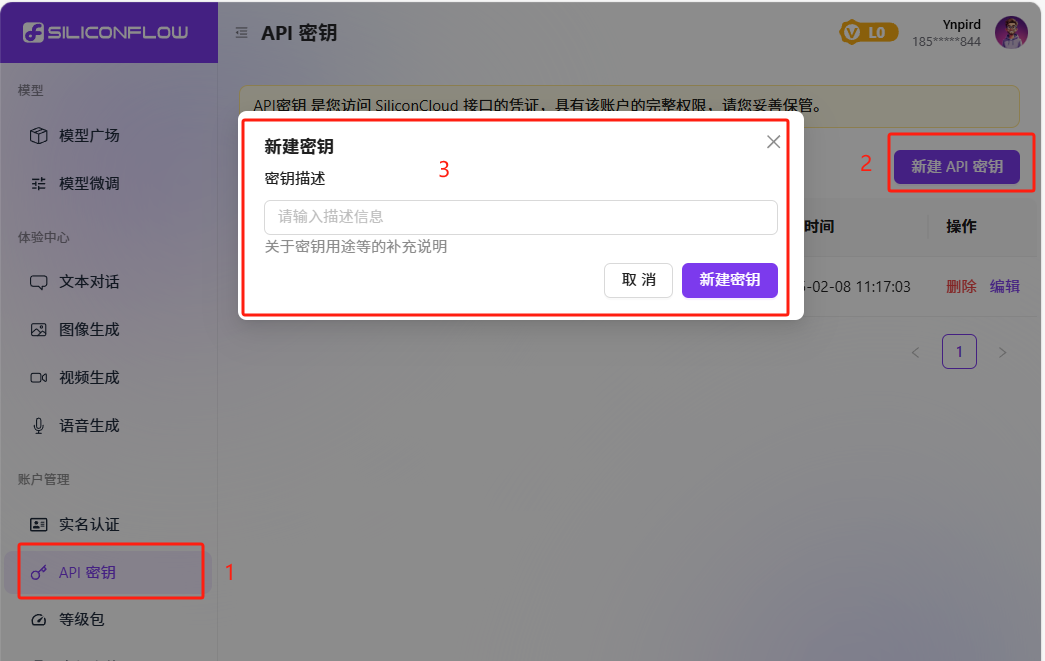

1. 注册硅基流动账号并生成API密钥。

- 访问硅基流动官网:https://cloud.siliconflow.cn/i/smrBisyV,并注册账号。邀请码可填写:smrBisyV。

- 登录后进入「API 密钥」页面,点击「新建密钥」,填写描述后生成并复制密钥。

2. 下载并安装Cherry Studio。

- 访问

Cherry Studio 官网:https://cherry-ai.com/download,选择对应系统的安装包(Windows/MacOS/Linux)。 - 双击安装包,根据提示安装即可。

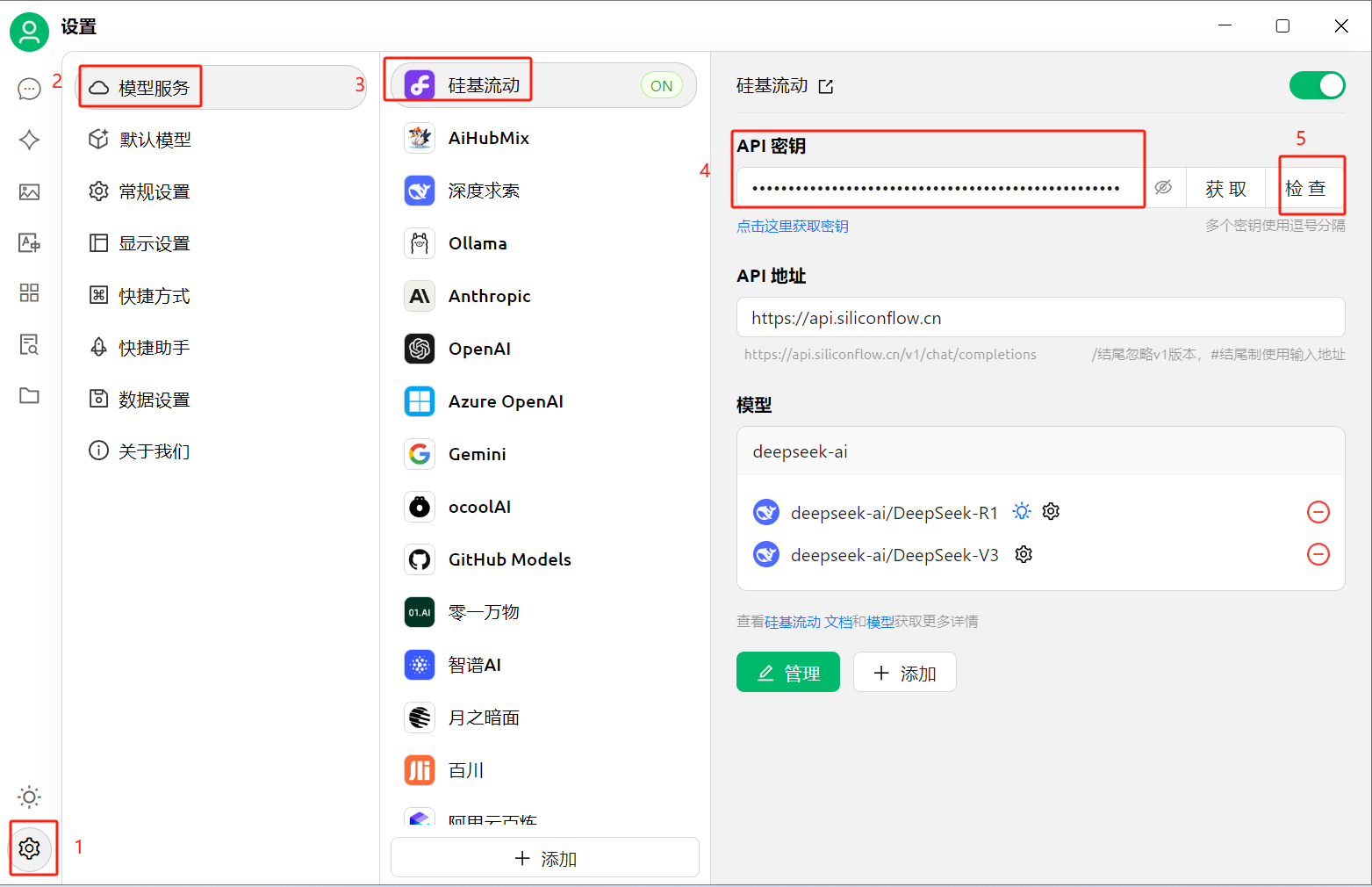

3. 配置Cherry Studio连接硅基流动。

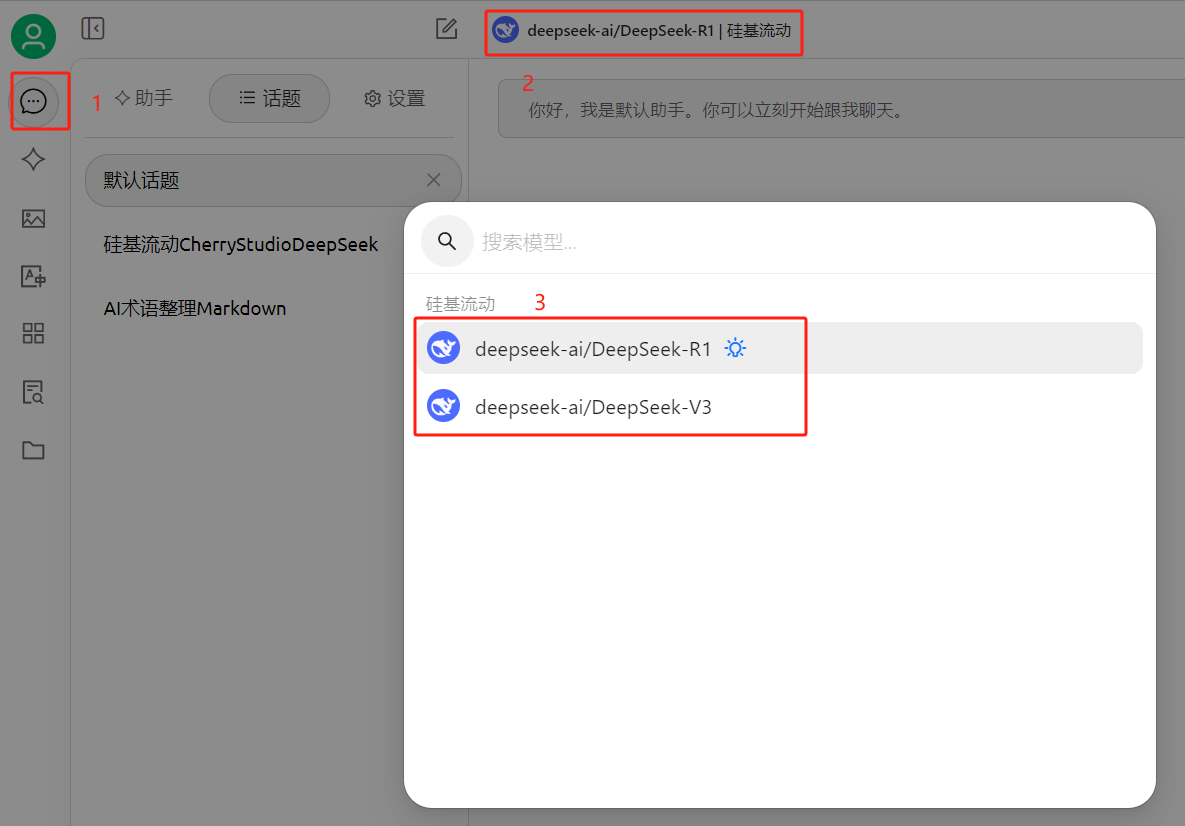

- 打开 Cherry Studio,点击左下角「齿轮图标」→「服务模型」→ 选择「硅基流动」,粘贴复制的 API 密钥。

- 点击「检查」按钮,确保密钥生效(晚高峰时可能延迟)。

4. 添加DeepSeek模型(如R1和V3)。

- 若存在自带模型(如 GPT-3),建议删除以简化界面。

- 若没有DeepSeek相关的模型,可以手动添加。点击「管理」→「添加模型」,输入模型 ID:

deepseek-ai/DeepSeek-R1(深度思考)。deepseek-ai/DeepSeek-V3(快速响应)。- 若需增强语义理解,可额外添加嵌入模型

BAAI/bge-m3。

5. 切换模型并开始使用。

- 在聊天界面顶部下拉菜单中,切换 R1 或 V3 模型。

- 输入问题后,R1 会逐步推理给出详细答案,V3 则快速返回结果。

2.3. 方案三:本地化部署DeepSeek

2.3.1. 关键步骤

- 硬件要求:需NVIDIA显卡(显存≥8GB)、内存≥16GB,推荐Ubuntu 20.04系统;

- 环境配置:安装Python 3.8+、Docker、CUDA 11.7,通过Git获取源码并配置模型权重(需HuggingFace API密钥);

- 服务启动:使用Docker启动服务,访问本地端口即可调用API。

2.3.2. 优缺点

- 优势:完全私有化、无网络延迟。

- 劣势:初期硬件成本高,需一定技术背景5。

2.3.3. 详细操作

我本人的电脑不满足要求,没有实际操作过。大家可查看其他资料完成相关的部署。